A part de nuages on peut aussi analyser nos données a travers le programme qui s’appelle Le Trameur. A la base de ce logiciel il y a une textométrie permettant de compter des éléments textuels dans les fichiers. Nous devons charger la base (l'onglet 'Cadre'--Contextes globaux) pour le programme puisse distinguer des unités élémentaires, afin de relever des séquences de caractères organisées et de comparer le vocabulaire des parties. Ensuite il faut bien vérifier la langue de travail dans l'onglet 'Param' et regarder si le texte est en UTF-8(sinon, on change l'encodage).

Chaque ligne dans le fichier global correspond à une ligne avec le motif indiqué. Ajouter un délimiteur permet bloquer l'analyse de contexte comme un texte entier et aussi de empêcher de trouver des cooccurrents non pertinents. Nous avons choisi $ comme délimiteur à la fin de chaque phrase pour bloquer les contextes.

Voici un exemple qui montre le vocabulaire existant et son fréquence. Il y a aussi la liste des mots formes contenant le motif ('identité' en français).

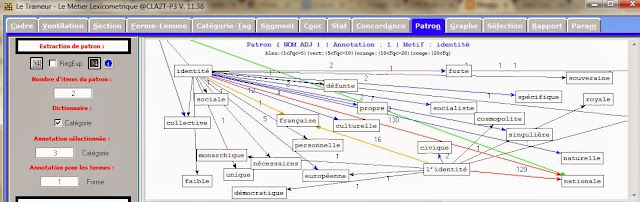

Sur Trameur nous pouvons aussi créer une arbre de dépendance c'est-a-dire on peut choisir des items du patron d'annotations (par exemple, NOM et ADJ) et regarder ensuite tous les phrases dans le fichier donnée contenant le motif (NOM) et adjectif relationnel. Cela se fait à l’aide de l’onglet 'patron' ou on peut indiquer le motif dans 'patron 2 graphe' pour afficher le graphe-arbre. Nous avon

On sait bien déjà que Le Trameur permet aussi d’extraire les cooccurrents(les mots liés au motif choisi). Pour cela dans l’onglet 'cooc' il faut taper le mot pole (pour nous c'est 'identité') et préciser un nombre pour la co-freq et le seuil (indique le poids du pole dans le texte) et puis cliquer sur 'calcul'. Le premier résultat avec beaucoup de mots pertinents:

Si on change le nombre de co-freq (2) et de seuil (6) on obtient que les cooccurents les plus pertinents.

S.